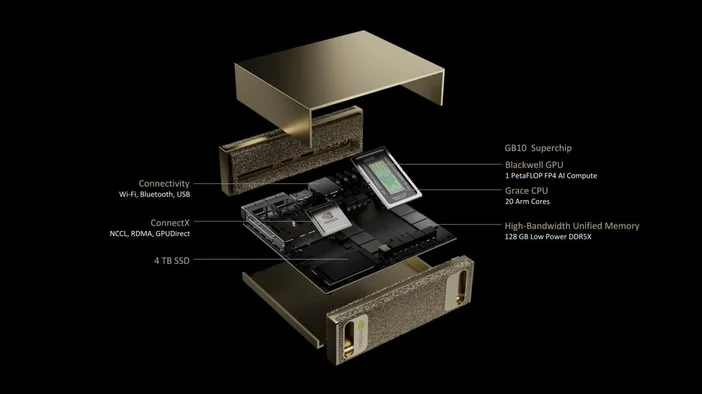

NVIDIA DGX Spark è un "supercomputer AI" tascabile per la tua scrivania. Basato sul superchip GB10 Grace Blackwell di NVIDIA, è progettato per consentire a sviluppatori e ricercatori di prototipare, mettere a punto ed eseguire inferenze su modelli di IA di grandi dimensioni a livello locale senza dover prenotare tempo su un cluster di data center. Offre fino a 1 petaFLOP (FP4) di prestazioni IA e 128 GB di memoria unificata in un formato compatto, con lo stack software IA di NVIDIA preinstallato.

Cosa c'è dentro?

- GB10 Grace Blackwell Superchip (CPU Grace + GPU Blackwell in un unico pacchetto)

- Memoria di sistema unificata LPDDR5x da 128 GB (CPU e GPU la condividono in modo coerente tramite NVLinkC2C)

- Rete NVIDIA ConnectX (10GbE integrata; ConnectX7 SmartNIC)

- Fino a 4 TB di spazio di archiviazione NVMe

- Ingombro ridotto: circa 150 x 150 x 50,5 mm; circa 1,2 kg

- DGX OS + stack software NVIDIA AI pronto all'uso

Cosa può fare effettivamente DGX Spark?

DGX Spark è stato progettato per la fase "fallo funzionare sulla mia scrivania" dell'IA:

- Prototipazione: crea e convalida modelli e app potenziate dall'intelligenza artificiale a livello locale, quindi trasferiscili su infrastrutture più grandi, se necessario.

- Messa a punto: modifica i modelli con fino a ~70 miliardi di parametri direttamente sul dispositivo.

- Inferenza: eseguire modelli all'avanguardia con fino a ~200 miliardi di parametri per test e convalida. Collegare due unità DGX Spark tramite ConnectX per raggiungere ~405 miliardi di parametri.

- Data Science: accelera le pipeline end-to-end con NVIDIA RAPIDS (e potenzia Apache Spark con RAPIDS Accelerator).

- Sviluppo di Edge e robotica: sperimenta framework come Isaac, Metropolis e Holoscan su un sistema desktop.

In che modo DGX Spark è diverso da un PC da gioco o da una workstation "normale"?

- Memoria unificata vs. VRAM separata: i 128 GB di DGX Spark sono una memoria di sistema coerente condivisa tra CPU e GPU, ideale per finestre di contesto di grandi dimensioni e un trasferimento efficiente dei dati. I PC convenzionali dividono la RAM e la VRAM della GPU.

- Silicio AI-First: i Tensor Core di quinta generazione e il supporto FP4 del GB10 sono progettati specificamente per i moderni LLM e agenti AI. Non si tratta di una macchina basata sui frame al secondo.

- Stack incluso: DGX OS e la piattaforma AI di NVIDIA sono preinstallati, quindi sei molto più vicino a "aprire il notebook, eseguire il modello" che a "installare driver, cercare container".

È la stessa "scintilla" di Apache Spark?

No, DGX Spark è un sistema hardware, mentre Apache Spark è un framework di elaborazione dati distribuito. Il vantaggio è che, se si utilizza Apache Spark, l'acceleratore RAPIDS di NVIDIA per Apache Spark può trasferire parte delle pipeline alla GPU e DGX Spark supporta tale stack.

Quanto costa e quando posso averne uno?

La pagina ufficiale di NVIDIA dedicata al prodotto DGX Spark si concentra sulle specifiche tecniche e sulle modalità di registrazione, mentre la disponibilità è garantita da NVIDIA e dai suoi partner OEM. NVIDIA ha annunciato che Acer, ASUS, Dell, GIGABYTE, HP, Lenovo e MSI offriranno i sistemi DGX Spark a partire da luglio (la disponibilità varia a seconda delle regioni).

Per quanto riguarda i prezzi, secondo alcune fonti le configurazioni partono da circa 3.999 dollari, anche se i prezzi finali dipendono dall'OEM e dalle opzioni di archiviazione. Alcune pagine di vendita al dettaglio riportano ancora la dicitura "in arrivo", quindi controllate gli elenchi dei partner per conoscere i prezzi e le disponibilità attuali.

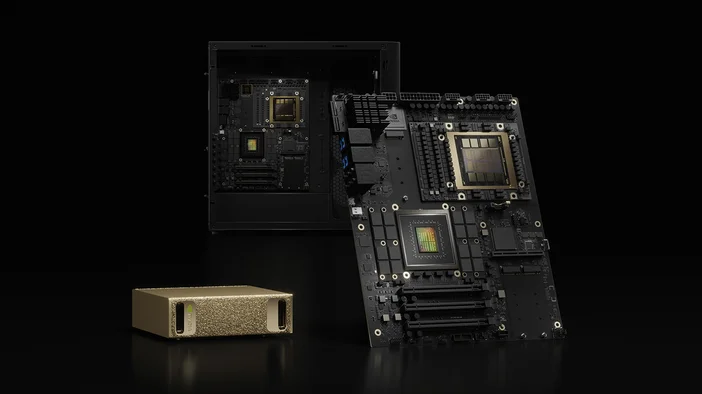

DGX Spark vs. DGX Station (il suo fratello maggiore)

Se DGX Spark è il tuo computer da tavolo per lo sviluppo, DGX Station è il potente computer desktop dedicato all'intelligenza artificiale. DGX Station (GB300 Ultra) è pensato per i lavori di addestramento e messa a punto più impegnativi, offrendo fino a ~20 petaFLOP (FP4) e centinaia di gigabyte di memoria unificata. È molto più grande e progettato per team o ambienti di laboratorio condivisi.

Ne vale la pena?

Sì, se sei uno sviluppatore di IA, un data scientist o un ricercatore che lavora costantemente su modelli LLM, agenti o modelli multimodali e hai bisogno di tempi di risposta rapidi a livello locale, gestione dei dati privati e uno stack software che si adatti perfettamente al data center o al cloud.

Forse no, se le tue esigenze si limitano al rendering GPU o ai giochi, o se hai già un accesso costante al cluster o al tempo HPC. In tal caso, una workstation tradizionale o i crediti cloud potrebbero essere più convenienti.

Tabella delle specifiche rapide (a colpo d'occhio)

- Prestazioni AI: fino a 1 PFLOP (FP4)

- Memoria: 128 GB LPDDR5x unificata (273 GB/s)

- Memoria: 1 TB o 4 TB NVMe (con crittografia automatica)

- Rete: 10GbE, ConnectX-7 SmartNIC, Wi-Fi 7, BlueTooth 5.3

- I/O: 4x USB-C, 1x HDMI 2.1a, NVENC/NVDEC (1/1)

- Dimensioni e peso: 150 x 150 x 50,5 mm; ~1,2 kg

- Sistema operativo: NVIDIA DGX OS