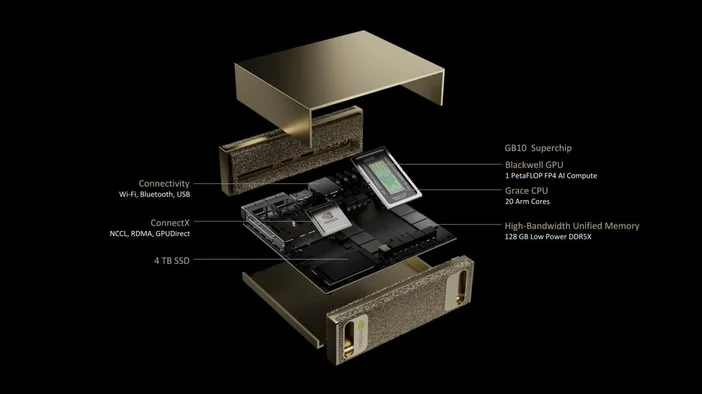

NVIDIA DGX Spark ist ein winziger „KI-Supercomputer“ für Ihren Schreibtisch. Er basiert auf dem GB10 Grace Blackwell Superchip von NVIDIA und wurde entwickelt, damit Entwickler und Forscher lokal Prototypen erstellen, Feinabstimmungen vornehmen und Inferenzberechnungen für große KI-Modelle durchführen können, ohne Zeit auf einem Rechenzentrumscluster reservieren zu müssen. Er bietet bis zu 1 PetaFLOP (FP4) KI-Leistung und 128 GB einheitlichen Speicher in einem kompakten Formfaktor, wobei die KI-Software von NVIDIA bereits vorinstalliert ist.

Was ist drin?

- GB10 Grace Blackwell Superchip (Grace-CPU + Blackwell-GPU in einem Gehäuse)

- 128 GB LPDDR5x einheitlicher Systemspeicher (CPU und GPU teilen ihn sich kohärent über NVLinkC2C)

- NVIDIA ConnectX-Netzwerk (10 GbE onboard; ConnectX7 SmartNIC)

- Bis zu 4 TB NVMe-Speicher

- Geringer Platzbedarf: ca. 150 x 150 x 50,5 mm; ca. 1,2 kg

- DGX OS + NVIDIA KI-Software-Stack sofort einsatzbereit

Was kann DGX Spark eigentlich?

DGX Spark wurde für die Phase der KI entwickelt, in der es darum geht, „es auf meinem Schreibtisch zum Laufen zu bringen“:

- Prototyping: Erstellen und validieren Sie Modelle und KI-gestützte Apps lokal und übertragen Sie sie bei Bedarf auf eine größere Infrastruktur.

- Feinabstimmung: Optimieren Sie Modelle mit bis zu ~70 Milliarden Parametern direkt auf der Box.

- Schlussfolgerung: Führen Sie modernste Modelle mit bis zu ~200 Milliarden Parametern zum Testen und Validieren aus. Verbinden Sie zwei DGX Spark-Einheiten über ConnectX, um in den Bereich von ~405 Milliarden Parametern vorzudringen.

- Data Science: Beschleunigen Sie End-to-End-Pipelines mit NVIDIA RAPIDS (und steigern Sie sogar die Leistung von Apache Spark mit dem RAPIDS Accelerator).

- Edge- und Robotik-Entwicklung: Experimentieren Sie mit Frameworks wie Isaac, Metropolis und Holoscan auf einem Deskside-System.

Wie unterscheidet sich DGX Spark von einem Gaming-PC oder einer „normalen“ Workstation?

- Einheitlicher Speicher vs. separater VRAM: Die 128 GB von DGX Spark sind ein kohärenter Systemspeicher, der von CPU und GPU gemeinsam genutzt wird und sich somit ideal für große Kontextfenster und eine effiziente Datenübertragung eignet. Herkömmliche PCs trennen RAM und GPU-VRAM.

- AI-First Silicon: Die Tensor-Kerne der fünften Generation und die FP4-Unterstützung des GB10 wurden speziell für moderne LLMs und KI-Agenten entwickelt. Dies ist keine Maschine, die auf Bilder pro Sekunde ausgelegt ist.

- Stack enthalten: DGX OS und die KI-Plattform von NVIDIA sind vorinstalliert, sodass Sie viel näher an „Notebook öffnen, Modell ausführen“ sind als an „Treiber installieren, nach Containern suchen“.

Ist es derselbe „Spark“ wie Apache Spark?

Nein, DGX Spark ist ein Hardwaresystem, während Apache Spark ein verteiltes Datenverarbeitungsframework ist. Das Schöne daran ist, dass Sie bei Verwendung von Apache Spark mit dem RAPIDS Accelerator für Apache Spark von NVIDIA Teile Ihrer Pipelines auf die GPU auslagern können und DGX Spark diesen Stack unterstützt.

Wie viel kostet es und wann kann ich eines bekommen?

Die offizielle Produktseite von NVIDIA für DGX Spark konzentriert sich auf Spezifikationen und Anmeldungen, während die Verfügbarkeit über NVIDIA und Partner-OEMs erfolgt. NVIDIA gab bekannt, dass Acer, ASUS, Dell, GIGABYTE, HP, Lenovo und MSI DGX Spark-Systeme anbieten werden, die ab Juli verfügbar sein werden (die regionale Markteinführung variiert).

Was die Preise angeht, so deuten Berichte auf Konfigurationen ab etwa 3.999 US-Dollar hin, wobei die endgültigen Preise vom OEM und den Speicheroptionen abhängen. Einige Einzelhandelsseiten zeigen noch immer „in Kürze erhältlich“, daher sollten Sie die Partnerlisten auf aktuelle Preise und Lagerbestände überprüfen.

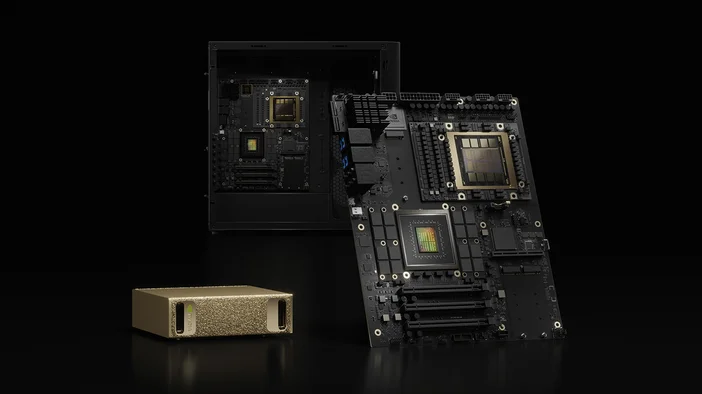

DGX Spark vs. DGX Station (sein großer Bruder)

Wenn DGX Spark Ihre Entwicklungsplattform für den Schreibtisch ist, dann ist DGX Station das leistungsstarke Desktop-KI-System. DGX Station (GB300 Ultra) ist für anspruchsvollste Trainings- und Feinabstimmungsaufgaben ausgelegt und bietet bis zu ~20 PetaFLOPs (FP4) und Hunderte Gigabyte einheitlichen Speicher. Es ist wesentlich größer und für Teams oder gemeinsam genutzte Laborumgebungen konzipiert.

Lohnt es sich?

Ja, wenn Sie ein KI-Entwickler, Datenwissenschaftler oder Forscher sind, der ständig an LLMs, Agenten oder multimodalen Modellen arbeitet und schnelle lokale Durchlaufzeiten, den Umgang mit privaten Daten und einen Software-Stack benötigt, der sich sauber auf das Rechenzentrum oder die Cloud abbilden lässt.

Vielleicht nicht, wenn Ihre Anforderungen sich auf GPU-Rendering oder Gaming beschränken oder wenn Sie bereits über einen stabilen Zugang zu Cluster- oder HPC-Zeit verfügen. In diesem Fall könnten eine herkömmliche Workstation oder Cloud-Credits kostengünstiger sein.

Schnellübersicht (auf einen Blick)

- KI-Leistung: bis zu 1 PFLOP (FP4)

- Speicher: 128 GB LPDDR5x Unified (273 GB/s)

- Speicher: 1 TB oder 4 TB NVMe (selbstverschlüsselnd)

- Netzwerk: 10 GbE, ConnectX-7 SmartNIC, Wi-Fi 7, Bluetooth 5.3

- E/A: 4x USB-C, 1x HDMI 2.1a, NVENC/NVDEC (1/1)

- Größe und Gewicht: 150 x 150 x 50,5 mm; ~1,2 kg

- Betriebssystem: NVIDIA DGX OS

JOIN OUR OFFICIAL CORSAIR COMMUNITIES

Join our official CORSAIR Communities! Whether you're new or old to PC Building, have questions about our products, or want to chat the latest PC, tech, and gaming trends, our community is the place for you.