Un nucleu CUDA este una dintre micile unități matematice din interiorul unui GPU NVIDIA care efectuează sarcinile de bază pentru grafică și calcul paralel. Fiecare nucleu se află într-un bloc mai mare numit Streaming Multiprocessor (SM), iar pe GPU-urile moderne GeForce „Blackwell” fiecare SM conține 128 nuclee CUDA. De aceea veți vedea un număr total de 21.760 nuclee CUDA pe un RTX 5090. Cipul are pur și simplu multe SM-uri, fiecare conținând aceste nuclee.

CUDA (platforma de calcul paralel NVIDIA) este partea software a poveștii: permite aplicațiilor și framework-urilor să trimită în mod eficient către aceste nuclee randări, AI și simulări paralele la scară largă.

Cum funcționează nucleele CUDA?

Gândiți-vă la un GPU ca la o fabrică concepută pentru lucrări în serie. Nucleele CUDA gestionează lucrările în grupuri de 32 de thread-uri care execută aceeași instrucțiune pe date diferite (un model pe care NVIDIA îl numește SIMT). Astfel, GPU-urile procesează mii de operații simultan. Fiecare SM are programatoare care mențin multe warp-uri în funcțiune pentru a ascunde latența memoriei și a menține nucleele ocupate.

O imagine mentală utilă:

- Nucleu CUDA = un lucrător individual (efectuează operații aritmetice precum adunări, înmulțiri).

- SM = un spațiu de lucru cu propriile sale programe de planificare, cache-uri, unități cu funcții speciale, Tensor Core(s) etc.

- GPU = întreaga fabrică, cu multe SM-uri care funcționează în paralel.

Nuclee CUDA vs. nuclee CPU (și alte nuclee GPU)

- Nu sunt nuclee CPU: un nucleu CUDA este o bandă aritmetică mai simplă, optimizată pentru randament, nu un nucleu CPU mare, reglat pentru latență, cu utilizare generală. GPU-urile se scalează prin colaborarea unui număr mare de astfel de benzi mici. (Ghidul de programare CUDA explică acest design orientat către randament.)

- Diferit de nucleele GPU specializate:

- Tensor Cores sunt motoare matematice matriciale care supraalimentează AI/ML și funcții precum DLSS;

- Nucleele RT accelerează trasarea razelor (traversarea BVH, teste rază/triunghi).

Acestea descarcă sarcini specifice, astfel încât nucleele CUDA să se poată concentra pe umbrire/calcul.

Credit imagine: NVIDIA

Mai multe nuclee CUDA înseamnă întotdeauna performanță mai bună?

De obicei, dar nu singure. Arhitectura contează foarte mult. De exemplu, generația Ampere de la NVIDIA a dublat randamentul FP32 pe SM față de Turing, astfel încât puterea „pe nucleu” s-a schimbat între generații. Ada a extins, de asemenea, cache-urile (în special L2), ceea ce sporește multe sarcini de lucru fără a modifica numărul de nuclee. Pe scurt: compararea numărului de nuclee CUDA între diferite generații nu este comparabilă.

Alți factori importanți:

- Viteza ceasului și marja de putere (cât de repede funcționează nucleele).

- Lățimea de bandă a memoriei și dimensiunile cache-ului (alimentarea nucleelor).

- Utilizarea nucleelor Tensor/RT (AI și ray tracing preiau sarcinile nucleelor CUDA).

- Drivere și software (cât de bine utilizează o aplicație GPU-ul prin CUDA).

Ce fac de fapt nucleele CUDA în practică?

- Jocuri/grafică: Acestea rulează programe de shader (vertex, pixel, compute) în fundal. Nucleele RT se ocupă de etapele grele de ray tracing; nucleele CUDA continuă să efectueze numeroase operații de umbrire și calcul în jurul acestora.

- Crearea și simularea conținutului: Soluții fizice, denoisers, render kernels, efecte video – multe dintre acestea sunt scrise pentru a profita de modelul paralel al CUDA.

- AI/ML: Operațiunile tensoriale sunt efectuate de nucleele tensoriale, dar o mare parte din preprocesare, postprocesare și operațiunile non-matriciale sunt încă efectuate de nucleele CUDA.

De câte nuclee CUDA am nevoie?

O regulă generală prietenoasă:

- Jocuri cu FPS ridicat 1080p–1440p: luați în considerare întregul GPU (arhitectură, frecvențe, memorie, caracteristici RT/Tensor), nu doar numărul de nuclee. Benchmark-urile sunt mai importante decât cifrele brute.

- 4K sau ray tracing intens: Veți beneficia de mai multe nuclee SM/CUDA și blocuri RT/Tensor puternice, plus lățime de bandă și cache.

- AI/calcul: Numărul de nuclee ajută, dar capacitatea Tensor Core, dimensiunea VRAM și lățimea de bandă a memoriei dictează adesea debitul.

Dacă doriți o verificare rapidă a scalabilității, RTX 5090 listează 21.760 nuclee CUDA, arătând modul în care NVIDIA calculează nucleele per SM pe mai multe SM-uri. Dar, din nou, creșterea performanței provine din designul total, nu doar din numărul de nuclee.

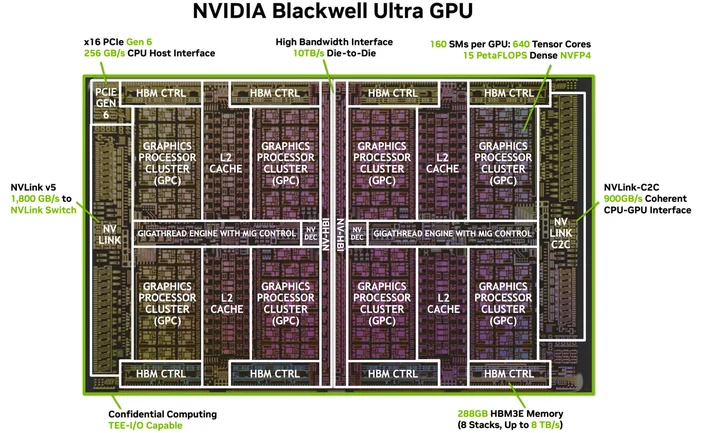

Credit imagine: NVIDIA

Am nevoie de software sau cabluri speciale? (HDMI pentru 4K al CUDA)

Nu aveți nevoie de un cablu special, dar aveți nevoie de pachetul software potrivit. CUDA este platforma NVIDIA; aplicațiile o utilizează prin intermediul driverelor, seturilor de instrumente și bibliotecilor. Multe aplicații și cadre populare sunt deja construite pentru a exploata accelerarea CUDA odată ce driverele NVIDIA și (atunci când este necesar) setul de instrumente CUDA sunt instalate, aplicațiile compatibile pur și simplu... o utilizează.

Ce GPU-uri acceptă CUDA?

CUDA rulează pe GPU-urile NVIDIA compatibile cu CUDA din toate liniile de produse (GeForce/RTX pentru jocuri și creație, RTX profesional și GPU-uri pentru centre de date). Ghidul de programare menționează că modelul se adaptează la multe generații de GPU-uri și SKU-uri; NVIDIA menține o listă a GPU-urilor compatibile cu CUDA și a capacităților lor de calcul.

Un nucleu CUDA este același lucru cu un „nucleu shader”?

În limbajul cotidian al GPU-urilor, da, în cazul GPU-urilor NVIDIA, „nucleele CUDA” se referă la ALU-urile FP32/INT32 programabile utilizate pentru umbrire și calcul general în interiorul fiecărui SM.

De ce numărul de nuclee CUDA diferă atât de mult între generații?

Deoarece arhitecturile evoluează. Ampere a modificat căile de date FP32 (mai multă muncă pe ciclu de ceas), iar Ada a revizuit cache-urile, astfel încât performanța să nu crească liniar odată cu numărul de nuclee.

Ce este o urzeală?

Un grup de 32 de thread-uri care se execută în mod sincronizat pe SM. Aplicațiile lansează mii de thread-uri; GPU-ul le programează ca warp-uri pentru a menține hardware-ul ocupat.

Nucleele CUDA ajută la AI?

Da, dar acceleratoarele importante pentru IA modernă sunt nucleele Tensor. Nucleele CUDA continuă să gestioneze o mare parte din activitatea din jurul acestor conducte.

JOIN OUR OFFICIAL CORSAIR COMMUNITIES

Join our official CORSAIR Communities! Whether you're new or old to PC Building, have questions about our products, or want to chat the latest PC, tech, and gaming trends, our community is the place for you.