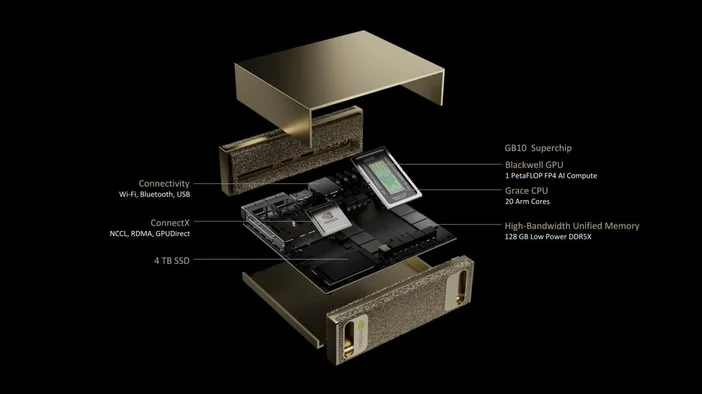

NVIDIA DGX Spark to niewielki „superkomputer AI” na biurko. Zbudowany w oparciu o superchip GB10 Grace Blackwell firmy NVIDIA, został zaprojektowany, aby umożliwić programistom i badaczom tworzenie prototypów, dostosowywanie i uruchamianie wnioskowania na dużych modelach AI lokalnie, bez konieczności rezerwowania czasu w klastrze centrum danych. Oferuje do 1 petaFLOP (FP4) wydajności AI i 128 GB zunifikowanej pamięci w kompaktowej obudowie, z preinstalowanym oprogramowaniem AI firmy NVIDIA.

Co jest w środku?

- GB10 Grace Blackwell Superchip (procesor Grace + procesor graficzny Blackwell w jednym pakiecie)

- 128 GB pamięci systemowej LPDDR5x (procesor i karta graficzna współdzielą ją spójnie za pośrednictwem NVLinkC2C)

- Sieć NVIDIA ConnectX (wbudowana karta 10GbE; ConnectX7 SmartNIC)

- Pamięć NVMe o pojemności do 4 TB

- Niewielkie wymiary: około 150 x 150 x 50,5 mm; około 1,2 kg

- DGX OS + pakiet oprogramowania NVIDIA AI gotowy do użycia

Co tak naprawdę potrafi DGX Spark?

DGX Spark został stworzony z myślą o fazie AI „zrób to na moim biurku”:

- Prototypowanie: Twórz i weryfikuj modele oraz aplikacje wzbogacone o sztuczną inteligencję lokalnie, a następnie, w razie potrzeby, przekazuj je do większej infrastruktury.

- Precyzyjne dostrajanie: dostosuj modele z maksymalnie ~70 miliardami parametrów bezpośrednio na urządzeniu.

- Wniosek: Uruchom najnowocześniejsze modele z maksymalnie ~200 miliardami parametrów do testowania i walidacji. Połącz dwie jednostki DGX Spark za pomocą ConnectX, aby osiągnąć ~405 miliardów parametrów.

- Nauka o danych: Przyspiesz kompleksowe procesy dzięki NVIDIA RAPIDS (a nawet zwiększ wydajność Apache Spark dzięki akceleratorowi RAPIDS).

- Rozwój technologii brzegowych i robotyki: Eksperymentuj z frameworkami takimi jak Isaac, Metropolis i Holoscan na systemie biurkowym.

Czym DGX Spark różni się od komputera do gier lub „zwykłej” stacji roboczej?

- Pamięć zunifikowana a oddzielna pamięć VRAM: 128 GB pamięci DGX Spark to spójna pamięć systemowa współdzielona przez procesor i procesor graficzny, co czyni ją idealną do obsługi dużych okien kontekstowych i wydajnego przesyłania danych. W tradycyjnych komputerach pamięć RAM i pamięć VRAM procesora graficznego są rozdzielone.

- AI-First Silicon: Piąta generacja rdzeni Tensor i obsługa FP4 w GB10 zostały zaprojektowane specjalnie z myślą o nowoczesnych modelach LLM i agentach AI. Nie jest to urządzenie liczące klatki na sekundę.

- W zestawie: DGX OS i platforma AI firmy NVIDIA są fabrycznie zainstalowane, więc jesteś znacznie bliżej „otwarcia notebooka i uruchomienia modelu” niż „instalowania sterowników i poszukiwania kontenerów”.

Czy to ta sama „iskra” co Apache Spark?

Nie, DGX Spark to system sprzętowy, natomiast Apache Spark to rozproszona platforma przetwarzania danych. Zaletą jest to, że jeśli korzystasz z Apache Spark, akcelerator NVIDIA RAPIDS dla Apache Spark może przenieść część procesów do procesora graficznego, a DGX Spark obsługuje tę platformę.

Ile to kosztuje i kiedy mogę to dostać?

Oficjalna strona produktu NVIDIA poświęcona DGX Spark skupia się na specyfikacji i rejestracji, natomiast dostępność produktu zależy od NVIDIA i partnerów OEM. NVIDIA ogłosiła, że firmy Acer, ASUS, Dell, GIGABYTE, HP, Lenovo i MSI będą oferować systemy DGX Spark, a ich dostępność rozpocznie się w lipcu (w zależności od regionu).

Jeśli chodzi o ceny, raporty sugerują, że konfiguracje będą dostępne już od około 3999 USD, choć ostateczne ceny zależą od producenta OEM i opcji pamięci masowej. Niektóre strony detaliczne nadal wyświetlają komunikat „wkrótce w sprzedaży”, więc aktualne ceny i stan magazynowy należy sprawdzić w ofertach partnerów.

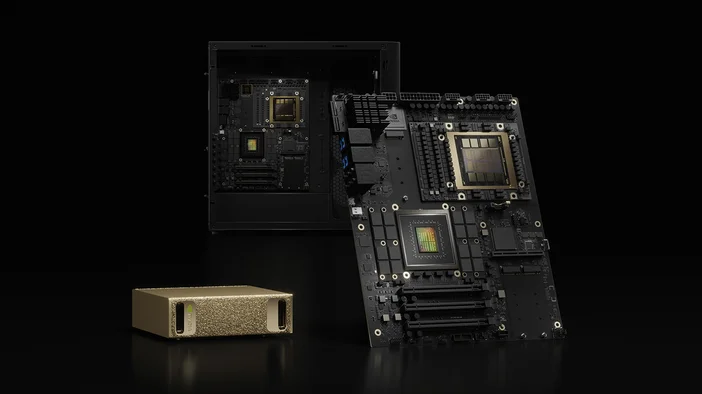

DGX Spark kontra DGX Station (jego większy brat)

Jeśli DGX Spark to Twoje biurkowe urządzenie programistyczne, to DGX Station jest potężnym komputerem stacjonarnym z funkcją sztucznej inteligencji. DGX Station (GB300 Ultra) jest przeznaczony do najbardziej wymagających zadań związanych ze szkoleniem i dostrajaniem, zapewniając wydajność do około 20 petaFLOPów (FP4) i setki gigabajtów zunifikowanej pamięci. Jest znacznie większy i przeznaczony dla zespołów lub wspólnych środowisk laboratoryjnych.

Czy to się opłaca?

Tak, jeśli jesteś programistą AI, analitykiem danych lub badaczem, który nieustannie pracuje nad modelami LLM, agentami lub modelami multimodalnymi i potrzebujesz szybkiej lokalnej obsługi, prywatnego przetwarzania danych oraz stosu oprogramowania, który można łatwo zmapować do centrum danych lub chmury.

Być może nie, jeśli Twoje potrzeby ograniczają się do renderowania GPU lub gier, lub jeśli masz już stały dostęp do klastra lub czasu HPC. W takim przypadku bardziej opłacalne może być tradycyjne stanowisko robocze lub kredyty w chmurze.

Tabela szybkich specyfikacji (w skrócie)

- Wydajność AI: do 1 PFLOP (FP4)

- Pamięć: 128 GB LPDDR5x zunifikowana (273 GB/s)

- Pamięć masowa: 1 TB lub 4 TB NVMe (samodzielnie szyfrująca)

- Sieć: 10GbE, ConnectX-7 SmartNIC, Wi-Fi 7, BlueTooth 5.3

- Wejścia/wyjścia: 4x USB-C, 1x HDMI 2.1a, NVENC/NVDEC (1/1)

- Wymiary i waga: 150 x 150 x 50,5 mm; ~1,2 kg

- System operacyjny: NVIDIA DGX OS

JOIN OUR OFFICIAL CORSAIR COMMUNITIES

Join our official CORSAIR Communities! Whether you're new or old to PC Building, have questions about our products, or want to chat the latest PC, tech, and gaming trends, our community is the place for you.