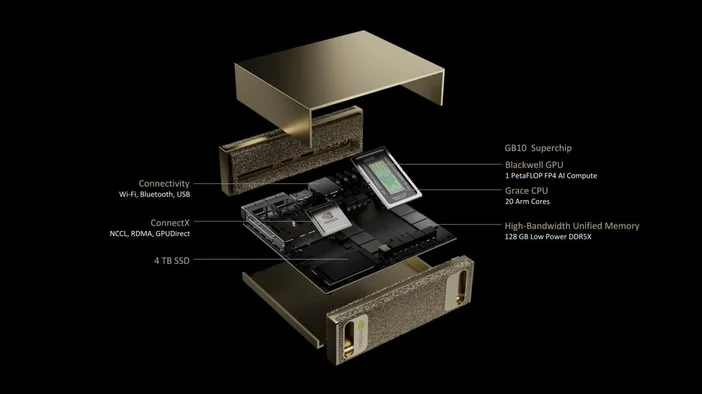

NVIDIA DGX Spark es un «superordenador de IA» de tamaño reducido para tu escritorio. Basado en el superchip GB10 Grace Blackwell de NVIDIA, está diseñado para permitir a los desarrolladores e investigadores crear prototipos, ajustar y ejecutar inferencias en grandes modelos de IA de forma local sin necesidad de reservar tiempo en un clúster de centro de datos. Ofrece hasta 1 petaFLOP (FP4) de rendimiento de IA y 128 GB de memoria unificada en un formato compacto, con la pila de software de IA de NVIDIA preinstalada.

¿Qué hay dentro?

- GB10 Superchip Grace Blackwell (CPU Grace + GPU Blackwell en un solo paquete)

- Memoria unificada del sistema LPDDR5x de 128 GB (la CPU y la GPU la comparten de forma coherente a través de NVLinkC2C)

- Redes NVIDIA ConnectX (10 GbE integrado; ConnectX7 SmartNIC)

- Hasta 4 TB de almacenamiento NVMe

- Tamaño reducido: aproximadamente 150 x 150 x 50,5 mm; alrededor de 1,2 kg.

- DGX OS + paquete de software NVIDIA AI listo para usar

¿Qué puede hacer realmente DGX Spark?

DGX Spark está diseñado para la fase «hacerlo funcionar en mi escritorio» de la IA:

- Creación de prototipos: cree y valide modelos y aplicaciones mejoradas con IA a nivel local y, a continuación, trasládelos a una infraestructura más grande si es necesario.

- Ajuste fino: Modifique los modelos con hasta ~70 000 millones de parámetros directamente en la caja.

- Inferencia: Ejecute modelos de última generación con hasta ~200 000 millones de parámetros para pruebas y validación. Conecte dos unidades DGX Spark a través de ConnectX para alcanzar los ~405 000 millones de parámetros.

- Ciencia de datos: acelere los procesos de principio a fin con NVIDIA RAPIDS (e incluso potencie Apache Spark con el acelerador RAPIDS).

- Desarrollo de Edge y robótica: Experimente con marcos como Isaac, Metropolis y Holoscan en un sistema de escritorio.

¿En qué se diferencia DGX Spark de un PC para juegos o una estación de trabajo «normal»?

- Memoria unificada frente a VRAM independiente: los 128 GB de DGX Spark son memoria de sistema coherente compartida entre la CPU y la GPU, lo que la hace ideal para ventanas de contexto grandes y un movimiento de datos eficiente. Los PC convencionales dividen la RAM y la VRAM de la GPU.

- Silicio con prioridad en IA: los núcleos Tensor de quinta generación y la compatibilidad con FP4 del GB10 están diseñados específicamente para los LLM y los agentes de IA modernos. No se trata de una máquina basada en fotogramas por segundo.

- Pila incluida: DGX OS y la plataforma de IA de NVIDIA vienen preinstaladas, por lo que estás mucho más cerca de «abrir el portátil y ejecutar el modelo» que de «instalar controladores y buscar contenedores».

¿Es la misma «chispa» que Apache Spark?

No, DGX Spark es un sistema de hardware, mientras que Apache Spark es un marco de procesamiento de datos distribuido. Lo bueno es que, si utilizas Apache Spark, el acelerador RAPIDS de NVIDIA para Apache Spark puede descargar parte de tus procesos a la GPU, y DGX Spark es compatible con esa pila.

¿Cuánto cuesta y cuándo puedo conseguir uno?

La página oficial de productos de NVIDIA para DGX Spark se centra en las especificaciones y las inscripciones, mientras que la disponibilidad se gestiona a través de NVIDIA y sus socios OEM. NVIDIA ha anunciado que Acer, ASUS, Dell, GIGABYTE, HP, Lenovo y MSI ofrecerán sistemas DGX Spark, cuya disponibilidad comenzará en julio (el lanzamiento regional varía).

En cuanto al precio, los informes sugieren configuraciones a partir de unos 3999 dólares, aunque los precios finales dependen del fabricante y las opciones de almacenamiento. Algunas páginas minoristas aún muestran «próximamente», así que consulte los listados de los socios para conocer los precios y el stock actuales.

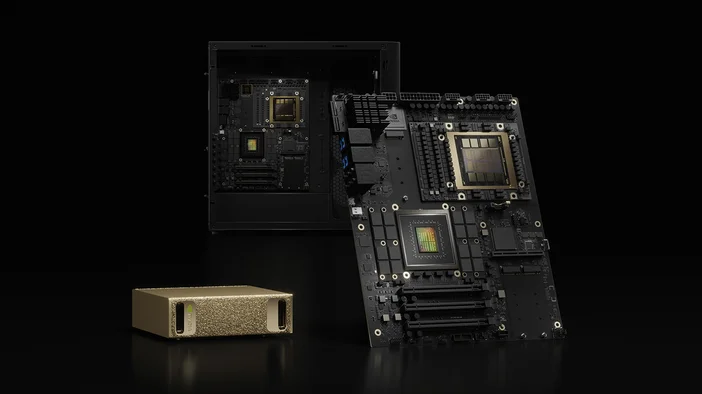

DGX Spark frente a DGX Station (su hermano mayor)

Si DGX Spark es su caja de desarrollo de escritorio, DGX Station es la potente estación de trabajo de IA. DGX Station (GB300 Ultra) está diseñada para las tareas de entrenamiento y ajuste más exigentes, y ofrece hasta ~20 petaFLOPs (FP4) y cientos de gigabytes de memoria unificada. Es mucho más grande y está diseñada para equipos o entornos de laboratorio compartidos.

¿Vale la pena?

Sí, si eres desarrollador de IA, científico de datos o investigador que trabaja constantemente con modelos de lenguaje grande (LLM), agentes o modelos multimodales y necesitas una respuesta local rápida, un manejo privado de los datos y una pila de software que se adapte perfectamente al centro de datos o la nube.

Quizás no, si tus necesidades se limitan al renderizado con GPU o a los videojuegos, o si ya tienes acceso constante a un clúster o a tiempo de HPC. En ese caso, una estación de trabajo tradicional o créditos en la nube podrían ser más rentables.

Tabla de especificaciones rápidas (de un vistazo)

- Rendimiento de IA: hasta 1 PFLOP (FP4)

- Memoria: 128 GB LPDDR5x unificada (273 GB/s)

- Almacenamiento: 1 TB o 4 TB NVMe (autocodificado)

- Redes: 10 GbE, ConnectX-7 SmartNIC, Wi-Fi 7, Bluetooth 5.3

- E/S: 4 puertos USB-C, 1 puerto HDMI 2.1a, NVENC/NVDEC (1/1)

- Tamaño y peso: 150 x 150 x 50,5 mm; ~1,2 kg

- Sistema operativo: NVIDIA DGX OS

JOIN OUR OFFICIAL CORSAIR COMMUNITIES

Join our official CORSAIR Communities! Whether you're new or old to PC Building, have questions about our products, or want to chat the latest PC, tech, and gaming trends, our community is the place for you.